Qu’est-ce que Docker et pourquoi l’utiliser ?

Sommaire

Introduction à Docker et à la conteneurisation

Depuis sa création en 2013, Docker a redéfini les standards du développement logiciel et des opérations informatiques. En s'appuyant sur les principes de la conteneurisation, Docker permet d'empaqueter une application et toutes ses dépendances dans une unité standardisée appelée conteneur. Ce concept d'isolation logicielle existait déjà, notamment avec les machines virtuelles (VM) et des technologies comme LXC (Linux Containers), mais Docker l'a rendu plus accessible, plus léger, et mieux intégré aux processus modernes de développement et de déploiement.

La conteneurisation consiste à exécuter plusieurs applications ou services isolés les uns des autres sur un même système d'exploitation. Chaque conteneur inclut tout ce dont une application a besoin pour fonctionner : son code, ses bibliothèques, ses configurations et même des outils spécifiques. Contrairement à une machine virtuelle, un conteneur ne contient pas de système d'exploitation complet, ce qui le rend beaucoup plus léger.

En parallèle, le concept des microservices a émergé comme une méthode clé dans la conception d'applications. Contrairement à l'architecture monolithique traditionnelle, où une application est construite comme un bloc unique, les microservices segmentent l'application en petits services indépendants. Chaque microservice gère une fonctionnalité ou un processus spécifique et communique avec les autres via des interfaces bien définies, souvent des API HTTP/REST. Cette approche offre plusieurs avantages, comme la facilité de maintenance, une meilleure scalabilité et une plus grande agilité dans le développement. Les équipes peuvent mettre à jour, déployer et échelonner chaque service indépendamment, sans perturber l'ensemble du système.

Lorsque Docker et les microservices sont combinés, ils offrent une synergie puissante. Docker permet de déployer chaque microservice dans son propre conteneur, assurant l'isolation des services et réduisant les conflits et les dépendances inter-services. Cette isolation renforce la sécurité, puisque chaque service est limité à son propre environnement. De plus, Docker facilite le déploiement continu et l'intégration continue, des pratiques essentielles pour une gestion efficace des microservices.

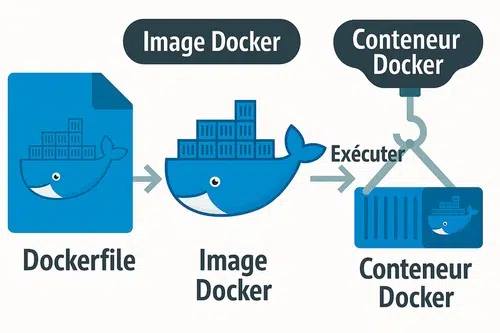

Docker repose sur trois concepts fondamentaux :

- Images : une image Docker est un modèle immuable qui contient tout ce qu'il faut pour exécuter une application. Elle sert de point de départ pour créer un conteneur.

- Conteneurs : un conteneur est une instance d’une image en cours d’exécution. Il est isolé mais peut interagir avec d'autres conteneurs ou avec l'extérieur via des interfaces réseau définies.

- Registres : les images Docker peuvent être stockées, partagées et téléchargées depuis des registres, comme Docker Hub (registre public) ou des registres privés.

Avant Docker, les développeurs et les administrateurs système faisaient face à plusieurs défis majeurs :

- Incohérence des environnements : une application fonctionnait sur l'ordinateur d'un développeur, mais pas sur le serveur de production.

- Complexité des configurations : installer et configurer manuellement une application avec toutes ses dépendances prenait du temps.

- Gestion lourde des machines virtuelles : les VM, bien qu'isolées, consommaient beaucoup de ressources système et étaient lentes à démarrer.

Docker a résolu ces problèmes en offrant une solution standardisée, légère et portable. Aujourd'hui, il est au cœur des méthodologies DevOps, facilitant la collaboration entre les équipes de développement et d'exploitation.

Cas d'utilisation typiques de Docker

Docker est utilisé dans presque tous les domaines du développement logiciel et de l'administration système. Il s'est imposé comme un outil essentiel dans les flux de travail modernes grâce à sa flexibilité, sa portabilité et sa capacité à résoudre des problèmes récurrents liés aux environnements de développement et de production. Voici des cas concrets où il excelle.

Développement logiciel rapide et cohérent

L'un des principaux défis dans le développement logiciel est la cohérence entre les environnements. Une application peut parfaitement fonctionner sur l'ordinateur d'un développeur, mais rencontrer des problèmes une fois déployée en test ou en production. Docker résout ce problème en offrant un environnement identique sur toutes les machines.

Par exemple, une équipe travaillant sur une application Node.js peut créer une image Docker contenant une version spécifique de Node.js, les dépendances nécessaires, et les configurations. Cette image est ensuite utilisée par tous les développeurs, garantissant que le code fonctionne de la même manière, quelle que soit la machine utilisée. Cela élimine les erreurs dues aux différences de versions de bibliothèques ou d'outils entre les environnements de développement.

De plus, Docker accélère la configuration des environnements. Au lieu de passer des heures à installer manuellement les dépendances, il suffit de lancer un conteneur préconfiguré en quelques secondes.

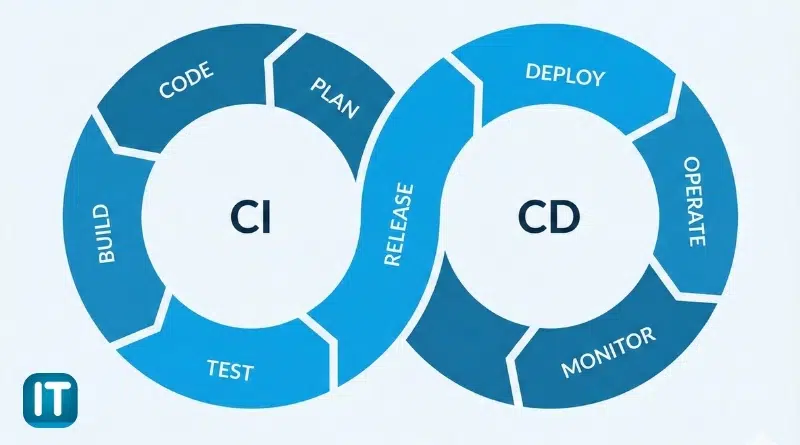

Intégration et déploiement continus (CI/CD)

L'intégration continue consiste à valider automatiquement chaque changement de code via des tests et des builds automatisés, tandis que le déploiement continu permet de livrer ces changements en production de façon fluide et fiable grâce à l'automatisation.

Docker est une pierre angulaire des pipelines d'intégration et de déploiement continus. Ces pratiques modernes permettent aux équipes de livrer rapidement du code de qualité en automatisant les étapes de construction, de test et de déploiement.

Les images Docker jouent un rôle crucial dans ce processus. Chaque modification du code source peut déclencher automatiquement la création d'une nouvelle image Docker. Cette image est ensuite testée dans un environnement isolé pour garantir qu'elle fonctionne comme prévu. Si les tests sont réussis, l'image est déployée en production.

Des outils comme Jenkins, GitLab CI ou GitHub Actions exploitent Docker pour garantir des tests reproductibles et des déploiements fiables. Par exemple, dans un pipeline CI/CD typique, Docker est utilisé pour :

- Construire une image contenant le dernier code source.

- Exécuter des tests automatisés dans des conteneurs.

- Déployer l'image en production, réduisant ainsi les risques d'erreur humaine.

Microservices

L'architecture microservices est une méthodologie de conception qui divise une application en plusieurs services indépendants, chacun ayant une responsabilité unique. Contrairement à une architecture monolithique, où toutes les fonctionnalités sont regroupées dans une seule application, les microservices permettent de découpler les fonctionnalités.

Docker simplifie la mise en œuvre des microservices en isolant chaque service dans un conteneur. Chaque conteneur contient tout ce dont le service a besoin pour fonctionner : code, bibliothèques, et configurations. Par exemple, dans une application de commerce en ligne, les services de gestion des utilisateurs, des produits, et des paiements peuvent être déployés dans des conteneurs distincts. Cela permet de :

- Mettre à jour ou corriger un service sans impacter les autres.

- Échelonner chaque service indépendamment en fonction de la charge.

- Faciliter la maintenance et le débogage.

L'isolation offerte par Docker réduit également les conflits de dépendances entre services et renforce la sécurité en limitant chaque conteneur à son propre environnement.

Migration d'applications existantes

De nombreuses entreprises doivent maintenir des applications héritées, souvent difficiles à déployer sur des infrastructures modernes. Docker offre une solution en permettant de conteneuriser ces applications sans avoir à les réécrire.

En encapsulant une application existante dans un conteneur, elle devient portable et facile à déployer. Par exemple, une application fonctionnant sur une ancienne version de PHP peut être exécutée dans un conteneur Docker avec la configuration requise, sans perturber les autres services ou systèmes. Cette approche permet :

- D'étendre la durée de vie des applications héritées.

- De les intégrer aux pipelines CI/CD modernes.

- De réduire les coûts liés à la refonte ou à la maintenance de ces applications.

Exécution d'environnements temporaires

Docker est idéal pour les scénarios nécessitant des environnements temporaires. Ces environnements peuvent être créés rapidement pour répondre à des besoins spécifiques, puis supprimés une fois qu'ils ne sont plus nécessaires.

Voici quelques exemples d'utilisation :

- Tester une nouvelle version d'une application : les développeurs peuvent exécuter une version expérimentale d'un service dans un conteneur isolé, sans impacter l'environnement principal.

- Démonstration client : un serveur web local contenant une application démo peut être lancé en quelques secondes.

- Analyses ou scripts uniques : des tâches spécifiques, comme des conversions de données ou des analyses de logs, peuvent être exécutées dans des conteneurs temporaires.

Ces environnements temporaires permettent de gagner du temps et d'éviter les risques associés à des modifications sur des systèmes en production.

Portabilité multi-cloud

Dans un monde où les entreprises utilisent de plus en plus de solutions cloud, la portabilité des applications est essentielle. Docker permet de déployer les applications sur n'importe quel fournisseur de cloud (AWS, Azure, Google Cloud) ou même sur des infrastructures sur site, sans modifications du code ou des configurations.

Cette flexibilité réduit le risque de dépendance à un fournisseur unique (vendor lock-in) et offre des options pour optimiser les coûts ou les performances. Par exemple :

- Une application peut être développée et testée localement dans des conteneurs Docker, puis déployée sur AWS pour la production.

- En cas de changement de stratégie ou de coûts prohibitifs, l'application peut être migrée vers un autre fournisseur sans effort supplémentaire.

En combinant Docker avec des outils d'orchestration comme Kubernetes, les entreprises peuvent gérer facilement des environnements hybrides ou multi-clouds.

Dans le prochain chapitre, nous parlerons des avantages et des inconvénients liés à l'utilisation de Docker dans un environnement DevOps.